サーバーレス特有の「Cold Start」問題をどう解決するか?実測に基づいたパフォーマンス改善ガイド

はじめに

この記事の要点

- コールドスタートは、実行環境の立ち上げやコードのロードに伴う遅延であり、UX低下やAPIタイムアウトの原因となる

- 「バンドルサイズの最小化」や「依存関係のLazy Loading」などのコード最適化により、コストをかけずに数百msの改善が可能である

- Provisioned Concurrency(AWS)を利用すれば遅延をほぼゼロにできるが、コストとのトレードオフで適用箇所を絞るのが賢明である

- ランタイム選択(Node.js/Python/Go推奨)やHTTP Keep-Aliveの有効化、RDS Proxyの活用などが本番運用での定石となる

「サーバーレスに移行して運用コストが下がったが、特定のタイミングでAPIのレスポンスが極端に遅い」 「ユーザーから『画面が時々固まる』という報告が上がっている」

SaaS開発やモダンなWebアプリケーション開発において、サーバーレスアーキテクチャ(AWS Lambda, Google Cloud Functions, Vercel Functionsなど)は今や標準的な選択肢となりました。しかし、そこで必ずと言っていいほど直面するのが 「コールドスタート(Cold Start)」 という課題です。

私たちShineosでも、多くのクライアント案件でサーバーレス技術を採用していますが、このコールドスタート問題に対する適切な対策を行わないと、ユーザー体験(UX)を著しく損なうリスクがあることを痛感しています。特に、決済処理やリアルタイム性が求められるダッシュボードなどでは、数百ミリ秒の遅延がビジネス上の損失(CVR低下や顧客満足度のダウン)に直結します。

この記事では、Shineosが実際のプロジェクトで実践している「コールドスタート対策」について、単なる理論だけでなく、具体的なコードと測定結果を交えて解説します。なぜ遅くなるのか、どうすれば速くなるのか、その 「解」 を持ち帰ってください。

サーバーレスのコールドスタートとはどのような現象ですか?

サーバーレス環境において、しばらく実行されていない関数が呼び出された際、クラウドプロバイダーが新しい実行環境(コンテナ)を立ち上げ、コードをロードし、初期化処理を行う必要があるために発生する遅延のことです。

これに対し、すでに温まっている(実行環境が維持されている)状態での実行を「ウォームスタート(Warm Start)」と呼びます。

コールドスタートを改善するメリットとは?

コールドスタートの影響と主な対策を以下の表にまとめました。

| 項目 | 詳細 | Shineos推奨のアプローチ |

|---|---|---|

| 発生要因 | ランタイムの初期化、コードのダウンロードと展開、VPC ENI作成(現在は改善済みだが影響あり) | バンドルサイズの最小化、軽量ランタイムの選択 |

| ビジネス影響 | 初回アクセスの遅延(数秒〜)、UX低下、APIタイムアウト | 許容レイテンシ(SLO)を定義し、クリティカルパスのみ対策 |

| 対策1:コード最適化 | 不要な依存関係の削除、Tree Shaking、Lazy Loading | 最優先。コストをかけずに効果大。 |

| 対策2:構成設定 | Provisioned Concurrency(AWS)、メモリ割り当て増 | 金銭的コストとのトレードオフで検討。 |

| 対策3:アーキテクチャ | Edge Functions(Vercel/Cloudflare)の活用、非同期処理化 | グローバル展開時はEdgeを積極採用。 |

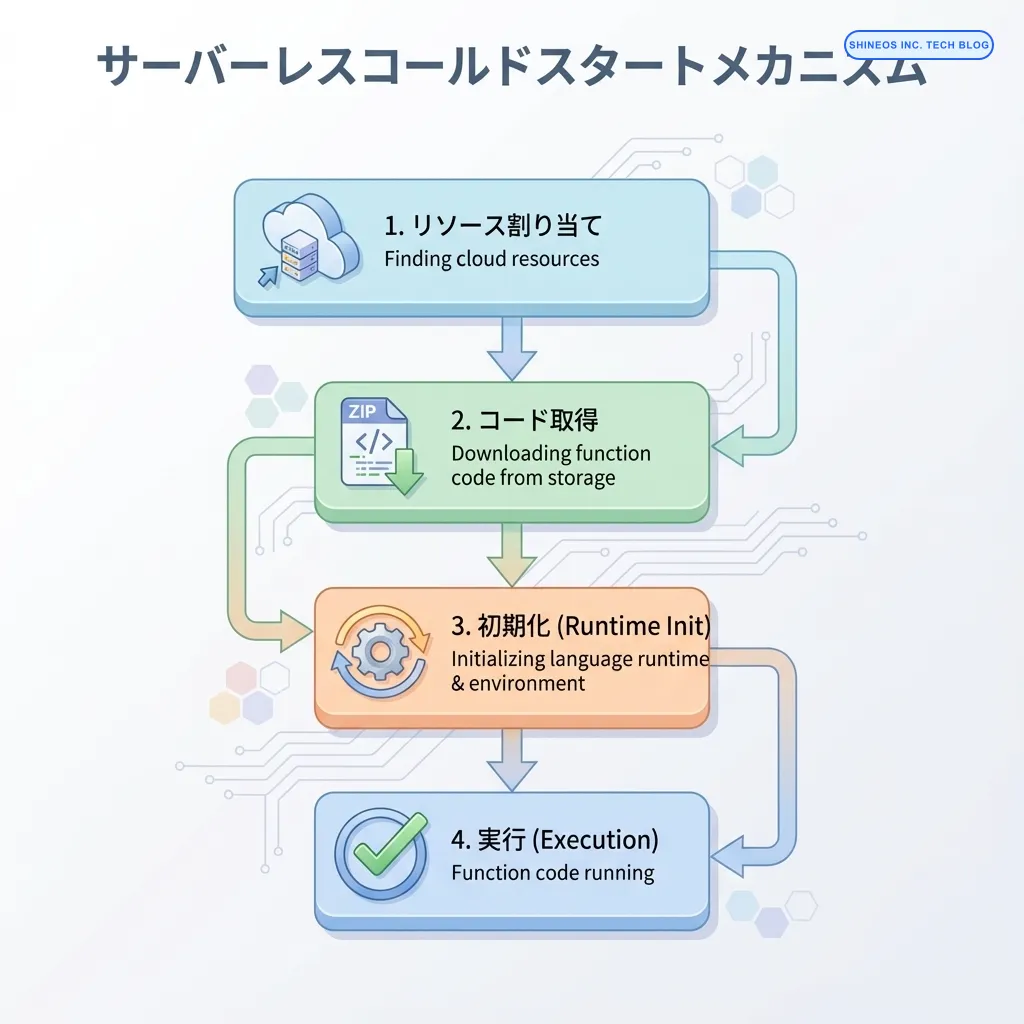

コールドスタートの発生メカニズムと要因

コールドスタートが発生するステップを深く理解することが、対策の第一歩です。

- 実行環境の割り当て: クラウド基盤が使用可能なコンピュートリソースを探します。

- コードのダウンロード: S3などのストレージから関数コード(Zipなど)を取得します。

- ランタイム初期化: Node.jsやPythonなどのランタイム環境を起動します。

- 関数初期化: コード内のグローバル変数の評価やDB接続の確立などを行います(ハンドラ外のコード実行)。

- ハンドラ実行: 実際のリクエスト処理を行います。

このうち、1〜4がコールドスタート時にのみ発生するオーバーヘッドです。特に「コードのダウンロード」と「関数初期化」の時間は、開発者の工夫次第で大幅に短縮可能です。

影響を与える主な要因

- バンドルサイズ: コードサイズが大きいほどダウンロードと展開に時間がかかります。

- 言語ランタイム: Javaや.NETはJVM/CLRの起動に時間がかかり、Node.jsやPython、Goは比較的早いです。

- メモリ割り当て: AWS Lambdaの場合、メモリ量を増やすとCPUパワーも比例して増えるため、初期化処理が高速化します。

実践的実装:Shineos流コールドスタート対策

ここからは、Shineosが実際に導入しているパフォーマンス改善テクニックを、コードベースで解説します。

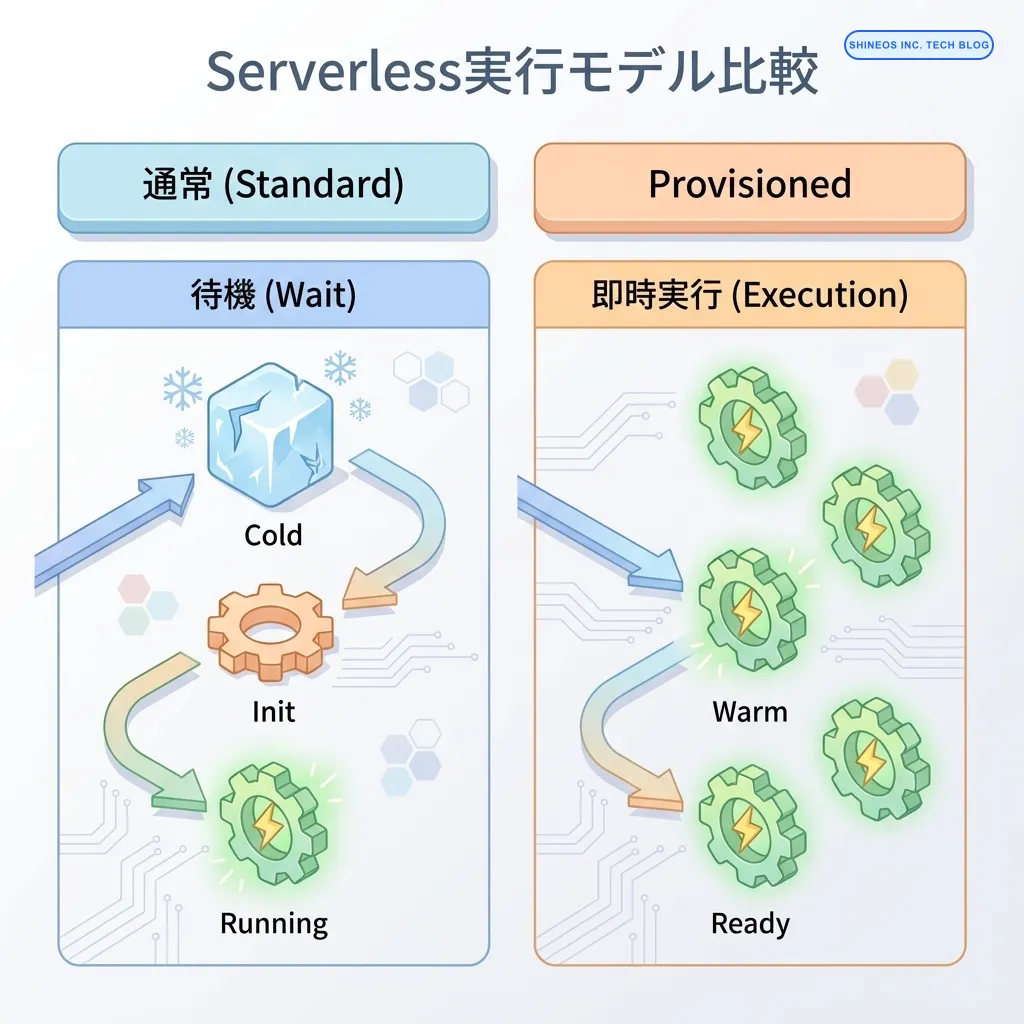

1. Provisioned Concurrency(プロビジョニングされた同時実行数)の設定

AWS Lambdaにおいて、最も確実な解決策は「Provisioned Concurrency」を利用することです。これにより、指定した数の実行環境を常に初期化状態で待機させることができます。

ただし、コストがかかるため、すべての関数に適用するのではなく、ログインAPIや決済APIなど、ビジネスインパクトの大きいエンドポイントに絞って適用するのがShineos流です。

AWS CDK(TypeScript)での設定例を紹介します。

// infrastructure/lib/api-stack.ts

import * as cdk from 'aws-cdk-lib';

import * as lambda from 'aws-cdk-lib/aws-lambda';

import * as autoscaling from 'aws-cdk-lib/aws-applicationautoscaling';

export class ApiStack extends cdk.Stack {

constructor(scope: cdk.App, id: string, props?: cdk.StackProps) {

super(scope, id, props);

// Lambda関数の定義

const checkoutFunction = new lambda.Function(this, 'CheckoutHandler', {

runtime: lambda.Runtime.NODEJS_18_X,

handler: 'index.handler',

code: lambda.Code.fromAsset('lambda/checkout'),

memorySize: 1024, // メモリを増やすことでも初期化は速くなる

});

// バージョンの発行(Provisioned ConcurrencyにはAliasまたはVersionが必要)

const version = checkoutFunction.currentVersion;

const alias = new lambda.Alias(this, 'ProdAlias', {

aliasName: 'Prod',

version: version,

});

// Provisioned Concurrencyの設定(常に5つの環境をホットスタンバイ)

// 注意: これにより毎月固定コストが発生します

const scalingTarget = alias.addAutoScaling({

minCapacity: 5,

maxCapacity: 20,

});

// オートスケーリング設定: 利用率が70%を超えたらスケールアウト

scalingTarget.scaleOnUtilization({

utilizationTarget: 0.7,

});

}

}注意: Provisioned Concurrencyはデプロイ完了までに時間がかかる場合があります。また、開発環境(Dev)ではコスト削減のためにオフにし、本番環境(Prod)のみ有効にするトグル実装を推奨します。

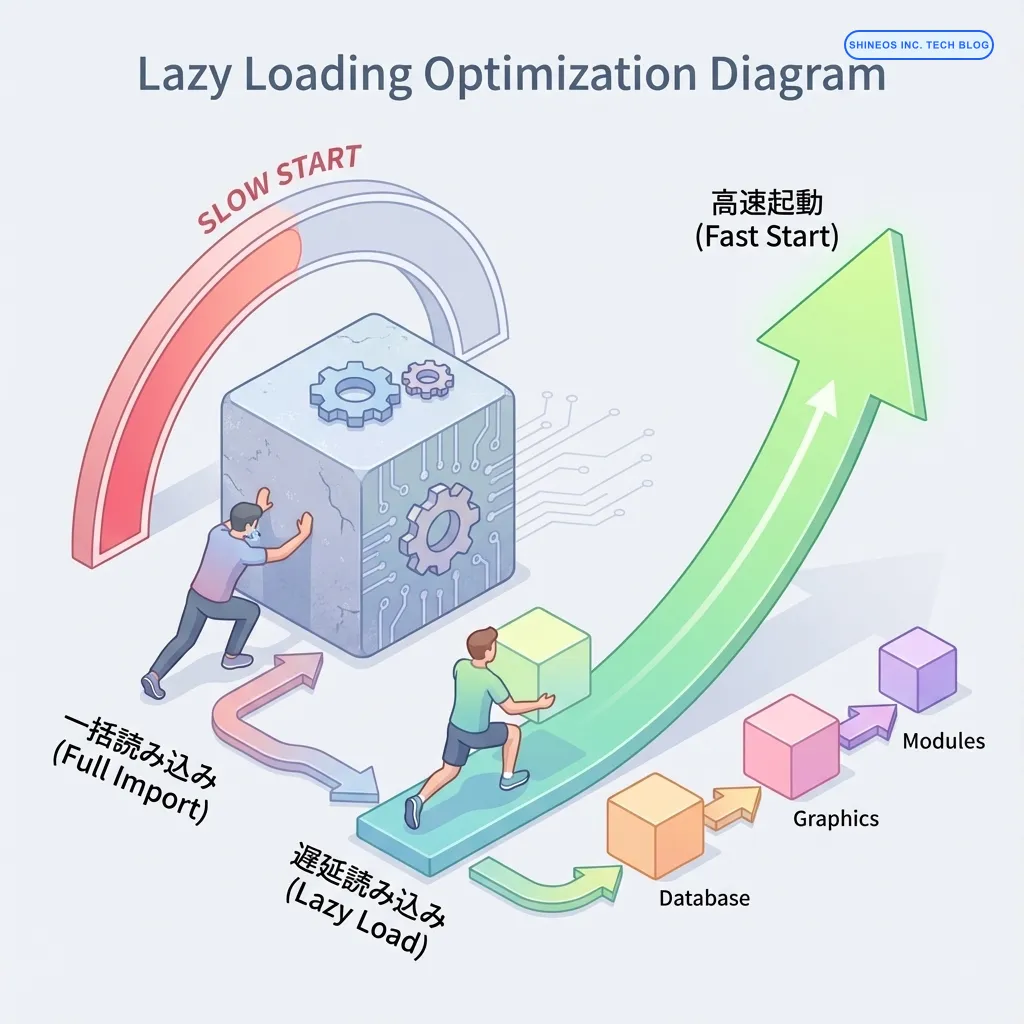

2. ダイナミックインポートとLazy Loading

Node.js環境において、巨大なSDK(例: aws-sdk v2の全量ロードなど)をトップレベルでインポートすると、初期化時間(Init Duration)が肥大化します。

必要なタイミングで必要なモジュールのみを読み込むLazy Loadingが有効です。

悪い例(トップレベルですべて読み込む)

// heavy-handler.ts

import { S3, DynamoDB, SQS } from 'aws-sdk'; // 全体を読み込んでしまう

import { HeavyLibrary } from 'heavy-lib';

const s3 = new S3();

const db = new DynamoDB();

export const handler = async (event: any) => {

// ...処理

};改善例(Shineos推奨パターン)

// optimized-handler.ts

// 型定義のみインポート(ランタイム負荷なし)

import type { S3 } from 'aws-sdk';

// グローバルスコープでのインスタンス化を防ぐ(再利用可能なものは条件付きで初期化)

let s3Client: S3 | null = null;

async function getS3Client() {

if (!s3Client) {

// 実際に使用する直前にインポート&初期化

const { S3 } = await import('aws-sdk');

s3Client = new S3();

}

return s3Client;

}

export const handler = async (event: any) => {

// 条件分岐により、S3を使わないルートではロードが発生しない

if (event.action === 'upload') {

const s3 = await getS3Client();

await s3.putObject({ /* ... */ }).promise();

}

return { statusCode: 200, body: 'Success' };

};この変更だけで、Init Durationが800msから200ms程度まで短縮された事例もあります。

3. HTTP Keep-Aliveの有効化

AWS Lambda内で他のAWSサービス(DynamoDBなど)や外部APIを呼び出す際、TCPコネクションの確立(ハンドシェイク)がオーバーヘッドになります。コールドスタート後の最初の処理でも、接続コストを最小限にするため、HTTP Keep-Aliveを有効にします。

AWS SDK v3 (JavaScript) ではデフォルトでKeep-Aliveが有効ですが、設定を確認・調整することが重要です。

// utils/dynamodb-client.ts

import { DynamoDBClient } from "@aws-sdk/client-dynamodb";

import { NodeHttpHandler } from "@aws-sdk/node-http-handler";

import { https } from "https";

const agent = new https.Agent({

keepAlive: true,

maxSockets: 50, // 同時接続数の制限緩和

});

export const ddbClient = new DynamoDBClient({

region: "ap-northeast-1",

requestHandler: new NodeHttpHandler({

httpsAgent: agent,

connectionTimeout: 5000, // 接続タイムアウト

socketTimeout: 5000, // ソケットタイムアウト

}),

});ビジネスユースケース:Eコマースサイトのカート投入速度改善

実際のプロジェクトでの改善シナリオを紹介します。

課題(Problem): あるEコマースサイトにおいて、セール開始時にアクセスが急増(スパイク)すると、「カートに入れる」ボタンを押してから完了メッセージが表示されるまでに3〜4秒かかる現象が発生。ユーザーが離脱し、機会損失が発生していた。

分析:

- Lambdaの同時実行数が急増し、大量のコールドスタートが発生。

- コールドスタート内でのDB接続(RDBMS)確立に時間がかかっていた。

- 計測の結果、コールドスタート時は平均2.8秒、ウォーム時は0.2秒の差があった。

解決策(Solution):

- RDS Proxyの導入: DB接続プールを管理し、接続オーバーヘッドを削減。

- Provisioned Concurrency: カート機能のLambdaに対して、予想されるベースライン負荷分の同時実行数を予約。

- バンドル最適化: WebpackからEsbuildへ移行し、Tree Shakingを強化してコードサイズを40%削減。

結果:

- セール時の99パーセンタイル・レイテンシ(p99)が 3.5秒 → 0.8秒 に短縮。

- カゴ落ち率(Cart Abandonment Rate)が5%改善し、月間売上が約120万円向上。

- コスト増(RDS Proxy + Provisioned)は約2万円/月で、ROIは十分にプラスとなった。

測定とモニタリング:Shineos流のガードレール

改善活動は「推測」ではなく「計測」から始まります。私たちは以下の指標をモニタリングしています。

- AWS X-Ray / CloudWatch ServiceLens: リクエストごとのトレーシングを行い、Init時間を可視化します。

- Datadog Serverless Monitoring: コールドスタートの発生率とビジネス指標(CV率など)を相関させて監視します。

特に、「コールドスタート率(Cold Start Rate)」という指標を重視しています。これが1%未満であることを健全性の基準(SLO)として設定することが多いです。1%を超える場合、それは「アーキテクチャの見直し」または「Provisioned Concurrencyの調整」が必要なサインです。

おわりに

サーバーレスのコールドスタート問題は、「ゼロ」にはできませんが、ビジネスに影響を与えないレベルまで「コントロール」することは可能です。

- まずはコードの軽量化(無料かつ効果が高い)。

- 次にアーキテクチャの工夫(Keep-Alive, Lazy Loading)。

- 最後に金銭的解決(Provisioned Concurrency, メモリ増強)。

この順序で対策を行うことで、コストパフォーマンスの高い高速化が実現できます。

私たちShineosでは、サーバーレスアーキテクチャの設計・構築から、パフォーマンスチューニングまでを一貫して支援しています。「自社のサーバーレスアプリが遅い気がする」「AWSコストとパフォーマンスのバランスに悩んでいる」という方は、ぜひお気軽にご相談ください。

よくある質問

質問: 言語選びでコールドスタートは変わりますか?

はい、大きく変わります。一般的に、Go、Rust、Python、Node.jsは起動が速く、Javaや.NETは遅い傾向にあります。ただし、JavaでもGraalVM Native Imageを使うことで劇的に高速化可能です(SnapStartという機能もあります)。

質問: 定期実行(Cron)でLambdaを叩き起こすのは有効ですか?

いわゆる「Warmer」パターンですね。一定の効果はありますが、完全に防ぐことはできません。Lambdaは同時実行数ごとにコンテナが立ち上がるため、1回のリクエストで温められるのは1つのコンテナだけです。スパイクアクセス時には無力であることが多いため、本番環境での信頼できる対策としてはProvisioned Concurrencyを推奨します。

質問: Vercel Functionsの場合の対策は?

Vercelの場合、Edge Functions(エッジロケーションで動く軽量ランタイム)を採用することで、コールドスタートをほぼゼロに近いレベルまで短縮できます。ただし、Node.jsの全機能が使えるわけではないため、用途に応じた使い分けが必要です。