LLM Hallucination AI信頼性

LLMの幻覚(Hallucination)対策 - 信頼性の高いAIシステムの構築方法

LLMが事実でない情報を生成する「幻覚」問題の原因と対策を徹底解説。RAG、プロンプト設計、検証プロセスなど実践的な手法を紹介します。

| 41 min read

Shineos Dev Team 3 件の記事

LLMが事実でない情報を生成する「幻覚」問題の原因と対策を徹底解説。RAG、プロンプト設計、検証プロセスなど実践的な手法を紹介します。

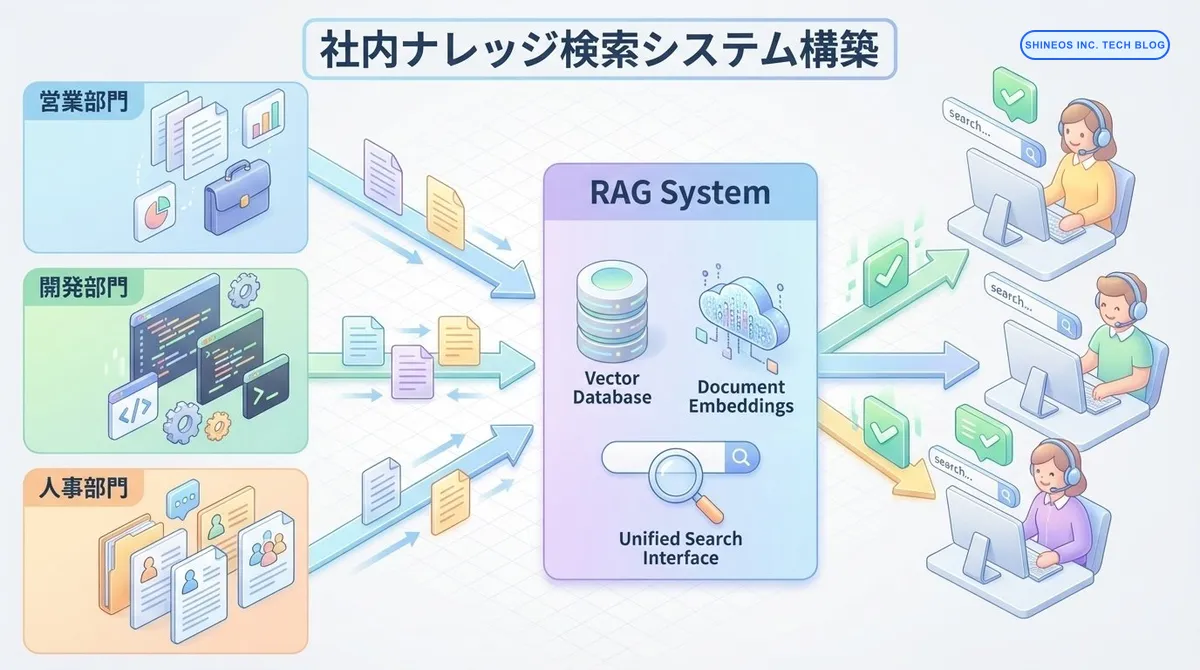

社内の知識が散らばっていて必要な情報がすぐに見つからない課題を、RAG技術で解決する実践的な構築方法を詳しく解説します。

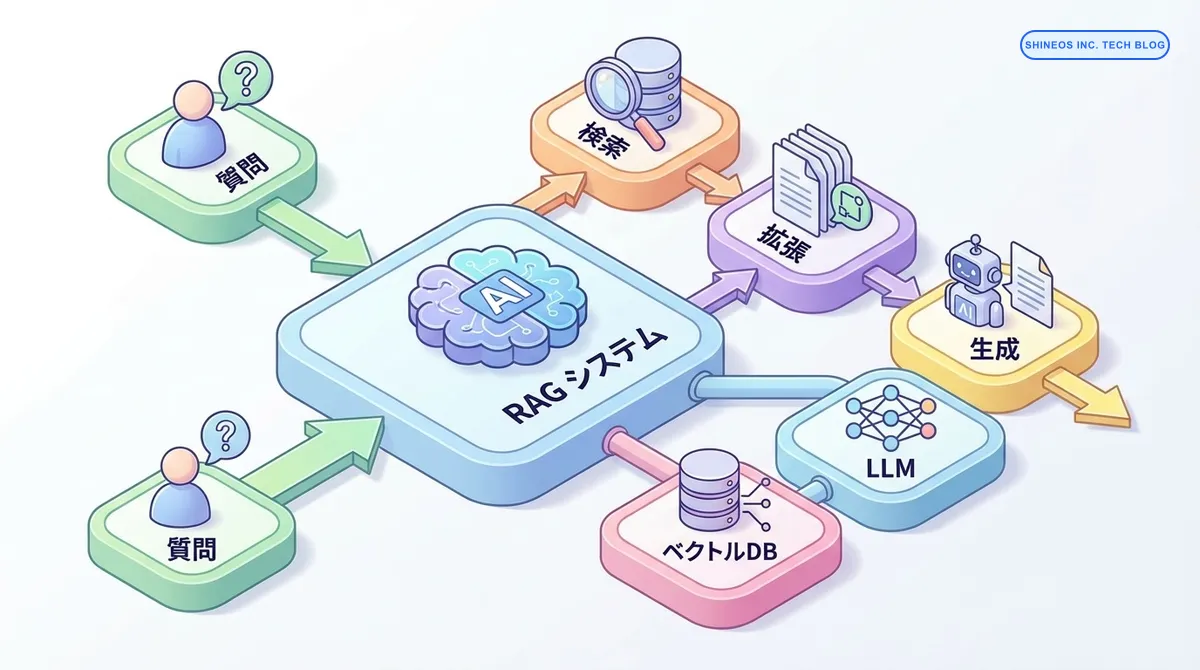

RAGの基本概念から実装パターン、本番環境での最適化手法まで、実務で使える検索拡張生成システムの構築方法を実践的に解説します。