Google Antigravity AIエージェント 開発効率化

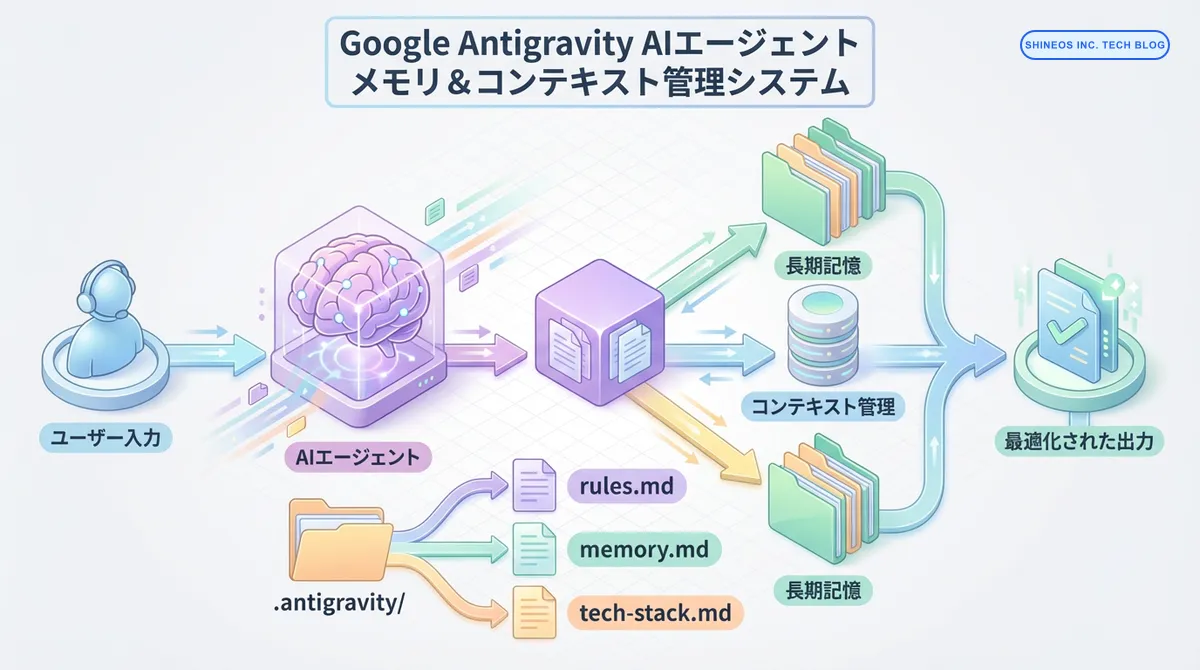

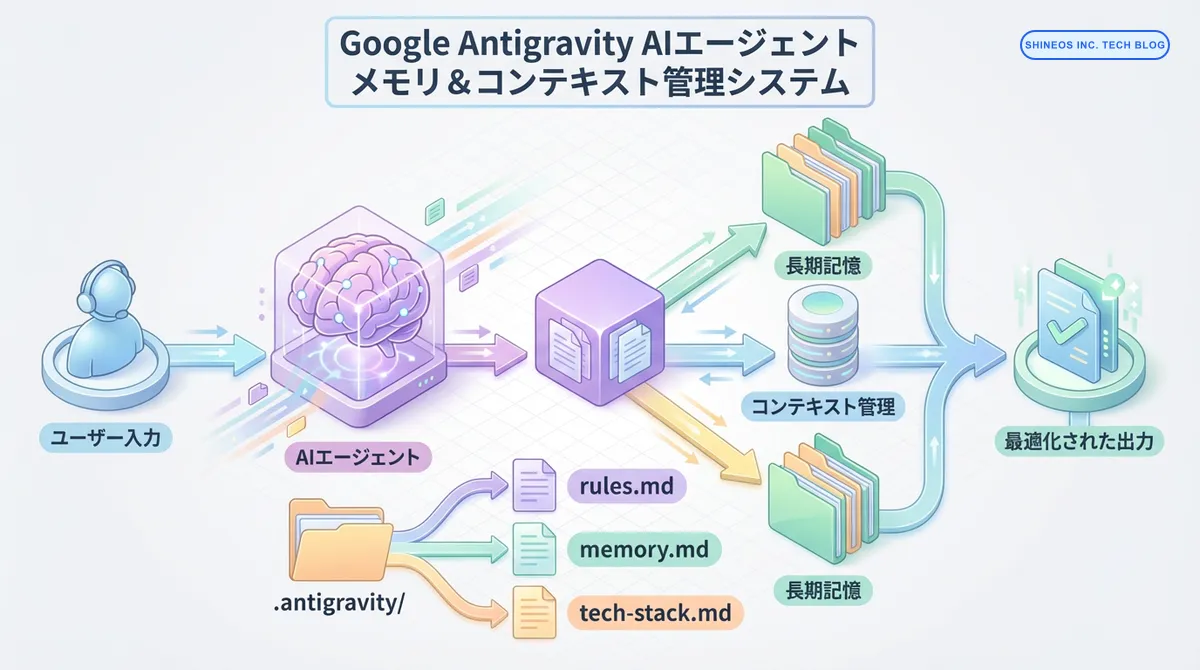

Google Antigravity 実践ガイド (Deep Dive) - 複雑なコンテキスト管理とメモリの最適化

Zennで公開中の実践ガイドの続編。Google Antigravityの「エージェントメモリ」と「コンテキスト管理」を深掘りし、大規模プロジェクトでの実践的な設定テクニックを解説します。

| 21 min read

Shineos Dev Team 3 件の記事

Zennで公開中の実践ガイドの続編。Google Antigravityの「エージェントメモリ」と「コンテキスト管理」を深掘りし、大規模プロジェクトでの実践的な設定テクニックを解説します。

LLMが事実でない情報を生成する「幻覚」問題の原因と対策を徹底解説。RAG、プロンプト設計、検証プロセスなど実践的な手法を紹介します。

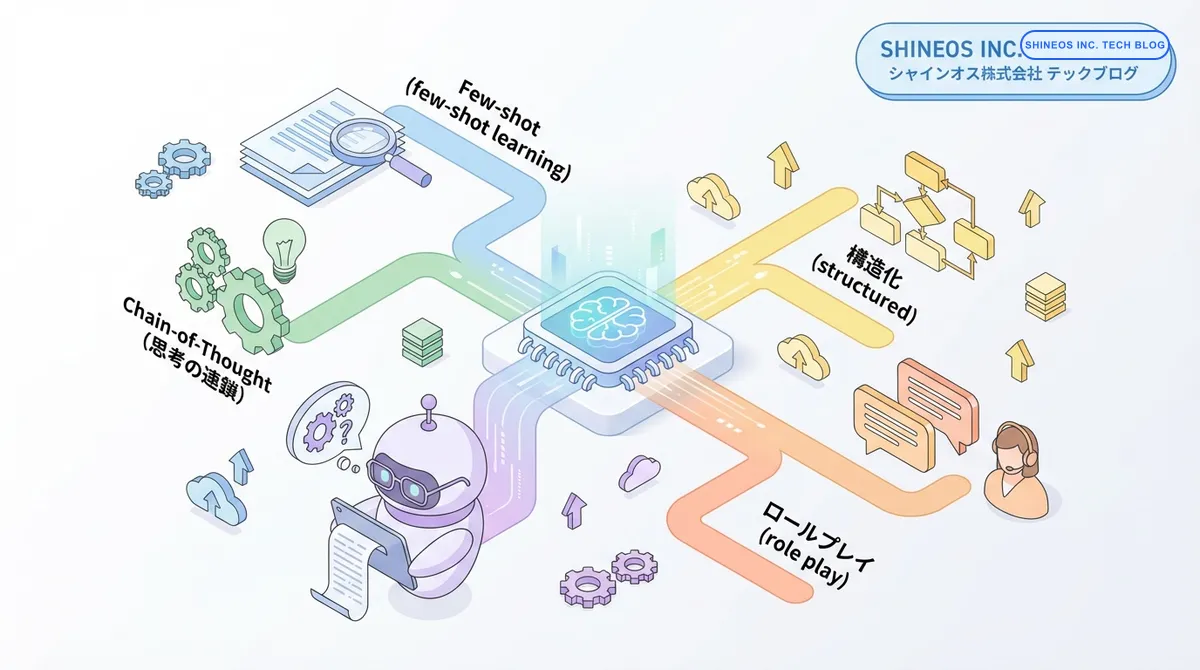

効果的なプロンプト設計の原則から高度なテクニックまで、LLMの性能を最大限に引き出すための実践的なプロンプトエンジニアリング手法を解説します。